本地部署 DeepSeek 大模型

最近 DeepSeek 老转圈圈和系统繁忙,所以决定自己部署一个

下载和安装 Ollama

Ollama 是一个强大的开源框架,旨在为本地运行大型语言模型提供便利。通过简单的安装指令,用户可以快速在本地运行开源大型语言模型

安装 Ollama

- 打开 Ollama 官网

- 下载对应系统的安装包

- 安装并启动 Ollama

Ollama 常用命令

sh

# 在命令行中运行模型

ollama run <模型名称>

# 列出可用模型

ollama list

# 查看模型状态

ollama ps

# 删除模型

ollama rm <模型名称>

# 启动 API 服务

ollama serve部署 DeepSeek R1 大模型

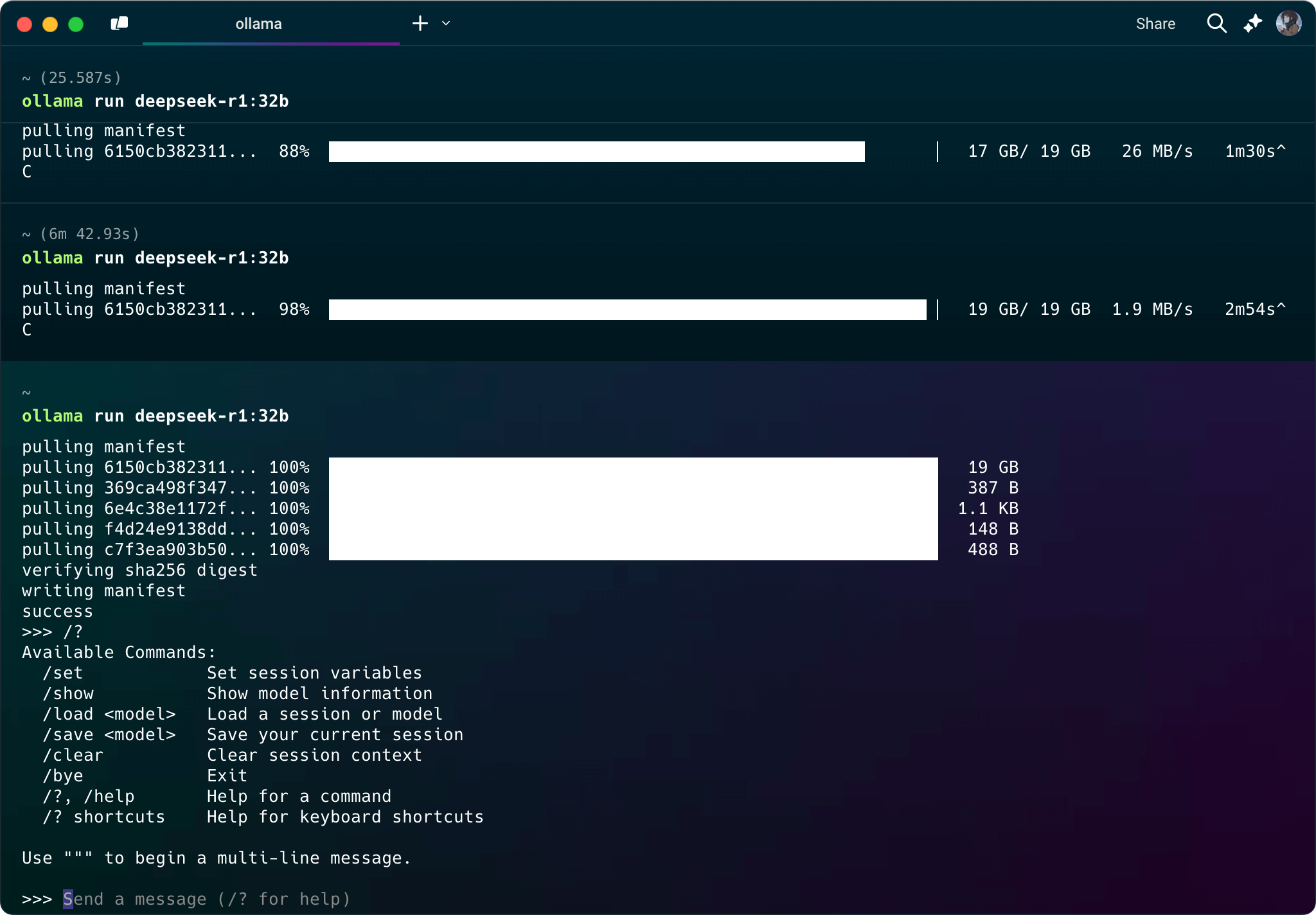

部署 DeepSeek R1 大模型前,需要确保系统具备足够的内存和存储空间(本人电脑为 M3 Pro 36GB 内存,运行 14B 模型没啥压力,运行 32B 模型会卡顿)

- 打开 DeepSeek R1 | Ollama

- 复制相应的模型安装指令

- 在终端中运行模型安装指令

sh

# 下载 deepseek-r1 8b 模型

ollama run deepseek-r1:8b解决 Ollama 下载模型速度变慢

如果在下载模型时速度变慢,可以使用 Ctrl + C 取消下载,然后重新运行下载指令。

接入到 WebUI 中

接入 WebUI 有多种方式:

- 自行搭建 WebUI

- 使用浏览器插件接入

- 使用第三方提供的 WebUI

自行搭建 WebUI

- 下载并安装 Docker

- 使用 Docker 运行 Open WebUI

sh

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main- 在浏览器中访问 http://localhost:3000

使用浏览器插件

- 安装浏览器扩展 —— Page Assist - 本地 AI 模型的 Web UI

- 在浏览器中访问

chrome-extension://jfgfiigpkhlkbnfnbobbkinehhfdhndo/options.html

使用第三方提供的 WebUI

以 Chatbox 为例

设置环境变量

默认情况下,Ollama 只允许本地访问。如果希望其他网站也能访问,需要设置环境变量 OLLAMA_ORIGINS。

- 打开终端

- 运行以下命令(以 MacOS 和 zsh 为例)

sh

# 允许所有来源访问

echo 'export OLLAMA_ORIGINS="*"' >> $HOME/.zshrc- 关闭并重新启动 Ollama 软件

使用 Chatbox

以 Chatbox 为例

- 在浏览器中访问 Chatbox

- 点击

设置 - 将模型提供方设置为

OLLAMA API(选择后会自动获取到本地的 Ollama 模型) - 点击

保存